▲ 미국 백악관은 12일(현지시각) 엔비디아, 구글, 오픈AI 등 AI 빅테크 경영진을 모아 AI 데이터센터의 높은 전력 소비 문제 해결방안을 논의했다. 사진은 AI 반도체 사용 전력의 20%가량을 차지하는 고대역폭메모리(HBM) 반도체. <그래픽 비즈니스포스트>

미국 정부가 AI 반도체가 상상 이상의 전력을 요구하면서 비용이 늘어나고 탄소배출 목표를 맞추기 힘들어질 것으로 예상되면서 해법을 찾기 위한 자리였다.

엔비디아가 올해 말 출시할 차세대 AI 반도체 ‘블랙웰’ 1개의 최대 전력 소모량은 1200와트(W)에 달한다. 이는 미국의 한 가정이 소모하는 전력량과 비슷하다. 이 같은 AI 반도체가 데이터센터에 수백에서 수천 개가 들어간다.

2030년 미국 내에서 데이터센터가 소비하는 연간 전력은 약 88테라와트시(TWh)로, 뉴욕시 전체가 소비하는 연간 전력량보다 약 1.6배 많을 것으로 예상된다.

AI 반도체와 AI 데이터센터의 전력 소비효율을 높이는 게 세계적으로도 큰 과제로 떠오를 전망이다.

이에 따라 AI 반도체 전력 소모의 약 20%를 차지하는 고대역폭메모리(HBM)를 제조하는 국내 삼성전자, SK하이닉스에 ‘전력 효율 개선’은 미래 HBM 시장의 주도권을 쥘 열쇠가 될 전망이다.

12일(현지시각) 미국 경제매체 쿼츠는 젠슨 황 엔비디아 최고경영자(CEO), 샘 알트만 오픈AI CEO, 루스 포랫 구글 최고재무관리자(CFO) 등 대표적 미국 빅테크 기업 경영진이 백악관을 방문했다고 보도했다.

이들은 미 정부 인사들과 만나 점점 더 과도한 전력을 필요로 하는 AI 반도체와 데이터센터의 전력 소비를 낮추는 방안을 논의한 것으로 전해졌다.

국제에너지기구(IEA)는 10년 내 데이터센터가 미국 전체 전력의 9.1%를 소비할 것으로 예상했다. 이는 현재보다 배 이상 늘어난 것이다.

젠슨 황 엔비디아 CEO는 백악관 회담 이후 CNBC 인터뷰에서 “AI 산업에 필요한 것은 에너지”라며 “우리는 가능한 가장 효율적이고, 확장 가능한 방식을 고려해야 한다”고 말했다.

▲ 구글은 2030년 탄소중립을 목표로 세웠지만, AI 데이터센터의 전력소모가 늘어나면서 이를 지키지 못하게 될 가능성이 높아졌다. <그래픽 비즈니스포스트>

게다가 AI에 필요한 높은 전력 수요는 각 기업들이 목표로 하는 탄소배출 문제와도 직결된다. 데이터센터 가동에 필요한 전력의 상당 부분이 화석연료 발전소에서 나오기 때문이다.

빅테크 기업들이 위치한 북미와 유럽연합(EU)은 환경 문제에 엄격해 각 기업들이 정부에 제출한 탄소배출 감소 목표치 달성이 필수다. 엔비디아는 2050년, 구글은 2030년 탄소중립을 이미 선언한 상황이다.

다만 AI 데이터센터의 막대한 전력소모는 이를 어렵게 만들고 있다. 지난해 구글의 온실가스 배출량은 전년보다 13%, 2019년과 비교해서는 48% 증가했다. 구글 측은 이와 관련해 AI 개발과 데이터센터 전력수요 증가를 원인으로 꼽았다.

이에 따라 AI 반도체에 들어가는 HBM 반도체는 갈수록 전력을 덜 사용하는 제품이 잘 팔릴 것으로 예상된다.

HBM은 AI 반도체 전력 소모의 20% 가량을 차지한다. 데이터센터가 사용하는 전력의 14% 정도는 HBM 메모리가 차지하고, 5%는 메모리 구동을 위해 소모되는 ‘팬(Pan)’에 사용된다.

SK하이닉스와 삼성전자는 차기 HBM 주도권을 위해 전력 효율을 대폭 개선한 HBM을 개발하고 있다.

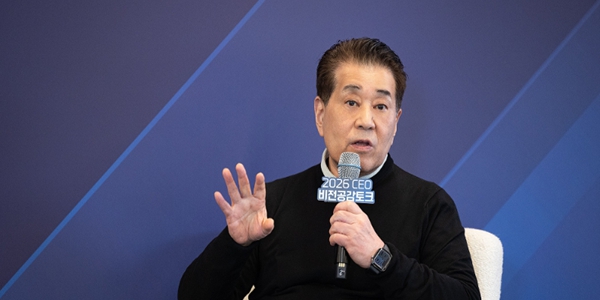

지난 7월 SK하이닉스 곽노정 사장 등 임원진은 2026년까지 HBM 전력효율을 2배로 개선하겠다는 목표를 밝혔다. 당초 2030년 달성 목표를 4년이나 앞당긴 것이다.

SK하이닉스는 독보적 ‘어드벤드스 MR-MUF’ 기술로 발열 관리를 통한 데이터센터 전체 전력효율 개선에도 집중하고 있다.

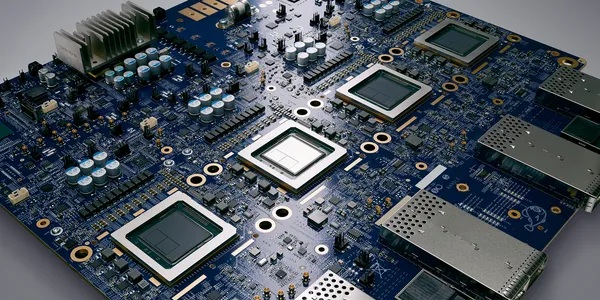

HBM은 전류가 흘러가며 많은 양의 열을 발생시키는데, 이를 냉각시키기 위해 대량의 전기가 필요하다. 실제 데이터센터 냉각시스템은 전체 전력 가운데 40~50%를 차지한다.

▲ SK하이닉스와 삼성전자는 HBM 전력효율 개선을 위해 기술 개발에 집중하고 있다. 사진은 마이크로소프트의 미국 내 한 데이터센터 내부 모습. <마이크로소프트>

SK하이닉스 관계자는 “HBM 세대가 바뀔수록 필연적으로 전력소모가 늘어나지만, 우리는 열 관리 기술에 강점을 지니고 있다”며 “AI 서버를 구축하는 기업들 입장에서 냉각에 소모되는 전력을 줄일 수 있어 수요가 더 많아질 것으로 본다”고 말했다.

SK하이닉스가 TSMC와 협력해 개발하는 6세대 HBM4의 전력효율도 개선될 전망이다.

김귀욱 SK하이닉스 HBM첨단 기술팀장은 올해 5월13일 국제메모리워크숍(IMW) 2024에서 “HBM4 전력 효율은 전작 HBM3E와 비교해 30% 개선될 것”이라고 말했다.

삼성전자 역시 HBM 전력효율 향상 기술개발에 집중하고 있다.

삼성전자는 2세대 HBM2 플레어볼트부터 뛰어난 전력 효율을 강조해왔다. 이후 HBM2 아쿠아볼트, 3세대 HBM2E 플래시볼트, 4세대 HBM3 아이스볼트까지 매번 더 나은 전력 효율을 이뤄냈다.

삼성전자 관계자는 “구체적 목표 수치를 밝히진 못하지만, HBM 전력효율 개선을 위해 기술개발에 매진하고 있다”며 “성능과 전력효율 모두를 끌어올리는 기술을 개발 중”이라고 말했다. 김호현 기자