![올해 미국 빅테크 'AI 투자' 경쟁 가열, 삼성전자 SK하이닉스 메모리 '슈퍼갑' 된다]()

| ▲ 미국 빅테크가 2026년 'AI 투자'를 더 늘리겠다고 밝히면서, SK하이닉스와 삼성전자의 메모리 공급 부족이 갈수록 심화할 것으로 전망된다. <그래픽 비즈니스포스트> |

[비즈니스포스트] 구글을 비롯한 미국 빅테크들이 올해 인공지능(AI) 인프라 투자를 지난해에 비해 더 크게 늘리기로 하면서, 삼성전자와 SK하이닉스가 생산하는 메모리반도체 공급 부족이 갈수록 심화할 것으로 전망된다.

마이크로소프트(MS)는 메모리 가격 상승이 설비투자(Capex) 상승에 직접적 영향을 미치고 있다며 공식적으로 우려를 표하기도 했으나, AI 경쟁에서 밀려나지 않으려면 투자를 더욱 확대할 수밖에 없는 상황에 놓여있다.

게다가 구글, MS, 아마존, 메타 등 주요 빅테크 모두 자체 주문형 AI 반도체(ASIC)를 본격적으로 상용화하고 있는 만큼, 고대역폭메모리(HBM)를 비롯한 메모리 가격의 상승세가 올해 지속될 가능성이 큰 것으로 분석된다.

4일(현지시각) 미국 알파벳(구글 지주사)은 2025년 4분기 실적을 발표하며 구글의 클라우드 매출이 176억6400만 달러(26조 원)로 2024년 4분기보다 48% 증가했다고 밝혔다. 연간 클라우드 매출은 700억 달러(102조 원)를 넘어섰다.

알파벳은 급증한 AI 수요 대응을 위해 올해 설비투자를 2025년의 2배 수준인, 1750억~1850억 달러(약 256조~271조 원)를 집행하겠다는 계획을 발표했다. 이는 당초 시장 예상치인 약 1200억 달러에 비해 50% 가량 크게 증가하는 것이다.

순다르 피차이 알파벳 최고경영자(CEO)는 "여전히 수요가 공급을 초과하고 있으며, 올해도 공급 제약 상황이 지속될 것으로 예상한다"며 "고객 수요를 충족하고 앞으로의 성장 기회를 활용하기 위해 투자를 확대할 필요가 있다"고 밝혔다.

메타, 마이크로소프트, 아마존 등 다른 미국 빅테크들도 2026년 AI 투자를 확대할 것으로 예상된다.

메타는 올해 설비투자에만 1150억~1350억 달러(약 164조~193조 원)를 집행하겠다고 밝혔는데, 이는 지난해보다 70% 이상 증가하는 것이다.

2025년 4분기에만 375억 달러를 설비투자에 지출한 MS는 올해도 1천억 달러 이상의 설비투자를 진행할 것으로 전망된다. 콘퍼런스 콜을 통해 급격한 설비투자 증가에 부담이 커지고 있다고 밝혔지만, 이미 AI 경쟁은 생존 문제가 되고 있기 때문이다.

아마존의 AI 투자 규모도 올해 1500억 달러(약 220조 원)에 이를 것으로 보이며, 오픈AI는 올 한해 약 170억 달러(약 23조 원)의 AI 투자 현금을 소진할 것으로 전망되고 있다. 오픈AI의 2026년 순손실 규모는 약 140억 달러(약 19조 원)에 달할 것으로 전망된다.

미국 투자은행 골드만삭스는 "미국 하이퍼스케일러(대규모 클라우드 서비스 사업자)의 2026년 총 설비투자는 5270억 달러(약 774조 원)으로 지난해 약 4천억 달러에 비해 1200억 달러(약 176조 원) 이상 증가할 것"이라며 "특히 AI 관련 투자 비중이 전체 투자의 약 75%를 차지할 것으로 전망되며, 이는 과거 1990년대 통신 버블 당시의 국내총생산(GDP) 대비 투자 비중(약 1.5%)에 근접하는 것"이라고 분석했다.

빅테크의 AI 투자 확대는 삼성전자와 SK하이닉스의 HBM 수요 증가로 연결된다.

미국 투자은행 뱅크오브아메리카에 따르면 2026년 세계 HBM 시장 규모는 546억 달러(약 80조 원)로 2025년 346억 달러 대비 58% 성장할 것으로 전망된다. 이는 HBM 수요 증가와 더불어 HBM4 출시에 따른 판매단가 상승 덕분이다.

HBM3E 12단의 엔비디아 공급 가격은 개당 450달러 선이었지만, HBM4 가격은 600달러를 웃도는 것으로 추정된다.

![올해 미국 빅테크 'AI 투자' 경쟁 가열, 삼성전자 SK하이닉스 메모리 '슈퍼갑' 된다]()

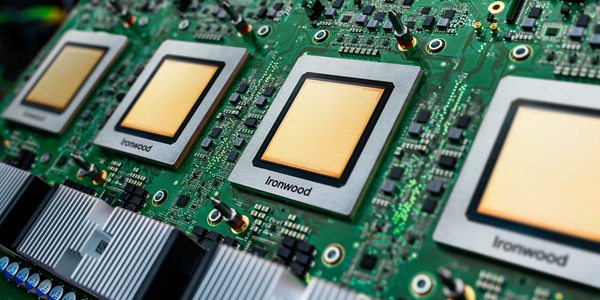

| ▲ 구글의 AI용 7세대 텐서프로세서(TPU) '아이언우드'. <구글> |

빅테크의 ASIC 자체 AI칩 채택 확대 기조도 삼성전자와 SK하이닉스 등 메모리 업체에 긍정적 요인이다.

엔비디아, AMD의 그래픽처리장치(GPU) 진영과 ASIC 자체 AI칩 진영의 제품 스펙 경쟁이 치열해질수록, 더 많은 용량의 HBM을 탑재할 필요성이 커지기 때문이다. 최근 구글이 공개한 7세대 텐서프로세서(TPU) '아이언우드'에는 192기가바이트(GB) 용량의 HBM3E가 적용됐으나, 8세대 TPU에는 288GB~448GB의 HBM4가 들어갈 것으로 전망되고 있다.

아마존은 '트레니움3'라는 자체 AI 칩을 보유하고 있으며, MS는 HBM4 288GB를 탑재하는 AI 칩 '마이아 200' 출시를 앞두고 있다. 메타도 올해 상반기 3세대 AI 칩 '엠티아(MTIA)'를 공개할 것으로 알려졌다.

시장조사업체 카운터포인트리서치는 "ASIC AI칩 물량은 2024년 대비 2027년 3배로 늘어날 것"이라며 "상위 10대 AI 하이퍼스케일러가 2024~2028년 누적으로 배포하는 ASIC 칩은 4천만 개를 넘을 것"이라고 내다봤다.

HBM 수요 급증과 함께 범용 D램, 낸드플래시의 가격 상승세도 올해 하반기까지 지속될 공산이 크다.

삼성전자와 SK하이닉스가 막대한 HBM 물량을 소화해야 하면서 범용 D램 생산량을 확대하기 어려워진 데다, AI 칩에 탑재되는 낸드플래시 용량도 급증하고 있기 때문이다.

엔비디아의 차세대 AI 칩 '베라 루빈'은 AI 추론 연산에서 발생하는 병목 현상을 해결하기 위해 고용량 낸드플래시 '솔리드스테이트드라이브(SSD)'를 활용하는데, 그 결과 엔비디아의 2026년과 2027년 SSD 수요 증가분은 각각 3460만 테라바이트(TB), 1억1520만TB에 달할 것으로 전망된다.

대만 시장조사업체 트렌드포스는 올해 전체 D램, 낸드 시장의 매출이 전년 대비 각각 144%, 112% 증가한 4043억 달러(약 593조 원), 1473억 달러(216조 원)에 이를 것이란 분석을 내놓기도 했다.

박유악 키움증권 연구원은 "2026년 범용 D램의 가격은 지난해보다 109%, 낸드 가격 역시 105% 급등할 것으로 전망된다"며 "범용 D램의 업황 호조는 메모리 기업의 HBM4의 가격 협상에도 우호적으로 작용할 것"이라고 내다봤다. 나병현 기자